Dernière mise à jour : 25 mai 2025

Un tournant historique dans la gouvernance de l’intelligence artificielle américaine

La Chambre des représentants des États-Unis a franchi une étape décisive le 22 mai 2025 en adoptant le “One Big Beautiful Bill Act” (H.R.1), un projet de loi budgétaire massif qui inclut une disposition controversée : un moratoire de 10 ans sur toute régulation de l’intelligence artificielle au niveau des États. Cette mesure, si elle est confirmée par le Sénat, pourrait redéfinir fondamentalement l’approche américaine de la gouvernance de l’IA jusqu’en 2035.

Les détails du moratoire : une interdiction sans précédent

Le projet de loi stipule qu’« aucun État ni aucune subdivision politique de celui-ci ne peut appliquer une loi ou un règlement régissant les modèles d’intelligence artificielle, les systèmes d’intelligence artificielle ou les systèmes de décision automatisés » pendant 10 ans. Cette interdiction, insérée dans la section 43201(c) du projet de loi de plus de 1100 pages, représente l’une des mesures fédérales les plus importantes en matière de politique technologique depuis des décennies.

Exceptions limitées

Le moratoire prévoit peu d’exceptions, permettant uniquement :

- L’application de toute loi “assortie d’une sanction pénale”

- Les règles visant à “supprimer les obstacles juridiques” ou à faciliter le déploiement de l’IA

- Les mesures qui favorisent l’adoption et l’utilisation des systèmes d’IA

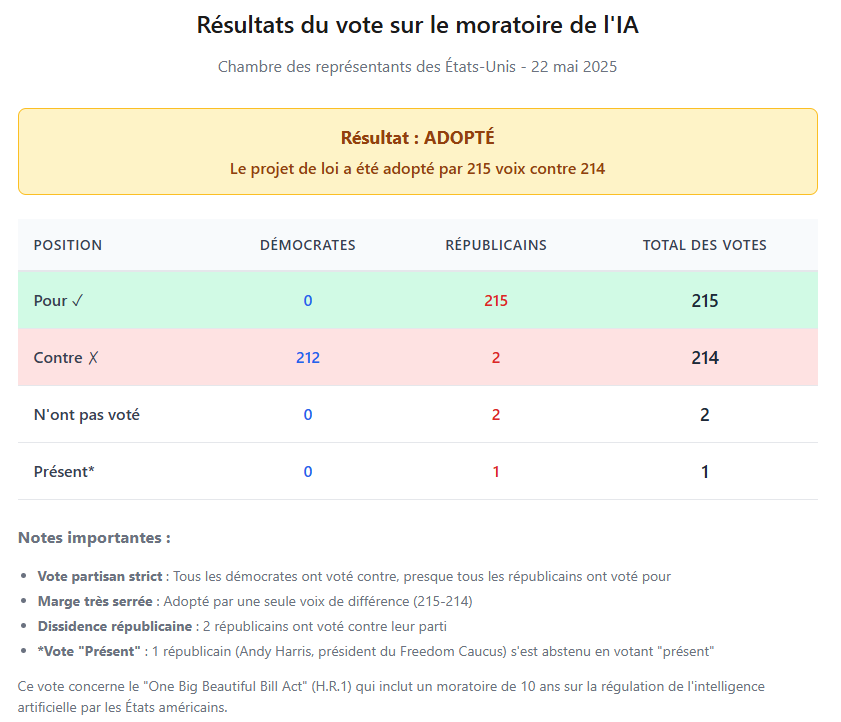

Un vote serré à la Chambre

Le projet de loi a été adopté par la Chambre par 215 voix contre 214, illustrant les divisions profondes au sein même du parti républicain sur cette question. Cette marge étroite d’une seule voix témoigne des tensions internes et des préoccupations soulevées par cette mesure radicale.

L’administration Trump et la dérégulation de l’IA

Cette initiative s’inscrit dans la stratégie plus large de l’administration Trump concernant l’intelligence artificielle. Le 23 janvier 2025, le président Trump a signé un décret révoquant l’ordre exécutif de Biden sur l’IA, qu’il considérait comme entravant l’innovation dans le secteur privé en imposant un contrôle gouvernemental sur le développement de l’IA.

La philosophie Trump : “L’innovation avant la régulation”

Il est de la politique des États-Unis de maintenir et d’améliorer la domination mondiale de l’Amérique en matière d’IA afin de promouvoir l’épanouissement humain, la compétitivité économique et la sécurité nationale. Cette approche privilégie explicitement la compétitivité et l’innovation par rapport aux considérations de sécurité et d’équité.

Une levée de boucliers bipartisane

L’opposition des procureurs généraux

Les procureurs généraux de 40 États américains, démocrates et républicains, ont signé une lettre vendredi pour exhorter le Congrès à renoncer à une mesure qui interdirait toute régulation de l’intelligence artificielle (IA) pendant 10 ans. Cette coalition bipartisane rare démontre l’ampleur des préoccupations soulevées par le moratoire.

« L’impact d’un moratoire aussi large serait considérable et totalement destructeur des efforts raisonnables déployés par les États pour prévenir les dommages connus liés à l’IA », notent-ils dans la lettre adressée aux sénateurs et représentants les plus influents des deux chambres américaines.

La mobilisation de la société civile

Plus de 140 organisations ont également signé une lettre ouverte pour s’opposer au moratoire, incluant :

- Des institutions universitaires (Université d’Essex, Georgetown Law)

- Des groupes de défense des droits civiques (Southern Poverty Law Center)

- Des syndicats et associations de travailleurs

- Des organisations de protection des consommateurs

Les implications concrètes : un vide juridique dangereux

Les domaines affectés

Le moratoire aurait des répercussions dans de nombreux secteurs :

1. Discrimination algorithmique

- Les systèmes de recrutement automatisés

- L’attribution de prestations sociales

- Les décisions de crédit et d’assurance

2. Protection des mineurs

- Interactions avec les chatbots

- Contenus générés par IA

- Deepfakes et cyberharcèlement

3. Vie privée et données personnelles

- Le moratoire menace particulièrement les lois sur la protection des données personnelles des États. Sans ces lois, les consommateurs ont peu de garanties quant à la manière dont les systèmes d’IA utilisent leurs données, obtiennent leur consentement ou prennent des décisions qui les concernent.

Le contexte international : une divergence avec l’Europe

L’approche américaine contraste désormais fortement avec la législation sur l’IA de l’Union européenne, qui impose des exigences strictes aux systèmes d’IA à haut risque. Alors que l’UE met en œuvre son AI Act avec des règles strictes sur la transparence et la responsabilité, les États-Unis semblent prendre la direction opposée.

Les défis pour les entreprises multinationales

Cette divergence réglementaire crée des défis significatifs :

- Coûts de conformité accrus

- Complexité opérationnelle

- Risque de fragmentation du marché global de l’IA

L’état actuel de la régulation au niveau des États

Au 19 mars 2025, près de 900 textes relatifs à l’IA étaient déjà en cours d’examen dans 48 États, contre 734 sur l’ensemble de l’année 2024. Ces initiatives locales couvrent une large gamme de préoccupations :

- Californie : Lois sur la transparence des systèmes d’IA et la protection contre les deepfakes

- New York : Réglementation des systèmes de recrutement automatisés

- Colorado : Législation contre la discrimination algorithmique

- Utah : Protection des données des mineurs

Les arguments des deux camps

Pour le moratoire

Les partisans avancent plusieurs arguments :

- Éviter la fragmentation réglementaire : Un patchwork de lois étatiques pourrait freiner l’innovation

- Maintenir la compétitivité américaine : Face à la Chine et à d’autres concurrents

- Donner du temps au Congrès : Pour élaborer une législation fédérale complète

Contre le moratoire

Les opposants soulignent :

- Protection des consommateurs : Les citoyens seraient laissés sans recours face aux abus

- Risques pour les populations vulnérables : Enfants, minorités, personnes âgées

- Vide juridique dangereux : Aucune responsabilité pour les entreprises tech

Le parcours législatif : prochaines étapes

Au Sénat

Le projet de loi doit maintenant être examiné par le Sénat, où son sort est incertain. Le leader de la majorité au Sénat, John Thune, a déclaré qu’il y a “des choses que nous devons ajuster ou modifier ou changer”, suggérant que des modifications substantielles pourraient être apportées.

Les défis procéduraux

Les démocrates prévoient de contester l’inclusion du moratoire sur l’IA dans le projet de loi budgétaire en invoquant la “Règle Byrd”, qui interdit l’inclusion de dispositions “étrangères” au budget fédéral dans le processus de réconciliation.

Le calendrier

L’administration Trump vise une adoption finale avant le 4 juillet 2025, mais les divisions au Sénat pourraient compliquer ce calendrier ambitieux.

L’impact sur l’innovation et la compétitivité

La course à l’IA avec la Chine

L’annonce de janvier 2025 selon laquelle les laboratoires d’IA chinois ont développé des modèles de raisonnement IA, comme DeepSeek, qui rivalisent avec leurs concurrents américains à une fraction du coût, a choqué l’industrie et l’administration. Cette pression concurrentielle intensifie le débat sur l’équilibre entre innovation et régulation.

Les implications pour l’industrie tech

Les géants de la Silicon Valley, dont Google, ont exprimé leur soutien au moratoire, y voyant une opportunité de développer leurs technologies sans contraintes réglementaires. Cependant, cette position n’est pas unanime dans l’industrie, certaines entreprises reconnaissant la nécessité de garde-fous éthiques.

Les alternatives proposées

Face aux critiques, plusieurs alternatives sont discutées :

- Un moratoire plus court : 2-3 ans au lieu de 10 ans

- Une approche sectorielle : Régulation ciblée sur les applications à haut risque

- Un cadre fédéral minimal : Établir des normes de base tout en permettant aux États de les renforcer

- Auto-régulation de l’industrie : Codes de conduite volontaires avec supervision fédérale

Conclusion : un débat fondamental sur l’avenir de l’IA

Le vote de la Chambre sur ce moratoire de 10 ans marque un tournant potentiel dans l’histoire de la régulation technologique américaine. Il soulève des questions fondamentales sur :

- L’équilibre entre innovation et protection des citoyens

- Le rôle respectif des États et du gouvernement fédéral

- La position des États-Unis dans la compétition mondiale sur l’IA

- Les valeurs qui devraient guider le développement de l’IA

FAQ

Le moratoire américain est une législation d’exception, officiellement appelée “AI Safety and National Security Act”, qui suspend pour 10 ans le développement et le déploiement de certaines catégories d’intelligence artificielle sur le territoire américain. La mesure cible spécifiquement les systèmes d’IA générative, les modèles de langage de plus de 100 milliards de paramètres et les systèmes autonomes dans les secteurs critiques comme la santé, la finance et les transports.

Plusieurs secteurs bénéficient d’exemptions totales ou partielles : les applications militaires et de défense nationale, la recherche universitaire sous supervision, les systèmes d’IA existants sous surveillance renforcée, et certaines applications jugées d’intérêt public comme la modération de contenu en ligne. Les projets de recherche climatique et de santé publique peuvent également obtenir des autorisations spéciales du Department of Homeland Security.

Le moratoire est établi pour une durée de 10 ans à compter de son entrée en vigueur, avec possibilité de révision triennale basée sur des critères de sécurité nationale et de compétitivité économique. Des clauses de révision anticipée pourraient être ajoutées par amendement parlementaire, particulièrement si la situation géopolitique ou les avancées technologiques l’exigent.

Les projections économiques divergent selon les sources. Goldman Sachs estime une perte de PIB de 2,1% sur dix ans (500 milliards de dollars), tandis que l’Economic Policy Institute projette la préservation de 15 millions d’emplois. Le secteur technologique anticipe une délocalisation de 50 milliards de dollars d’investissements vers l’Europe et l’Asie sur les trois prochaines années, accompagnée d’un exode de talents vers des juridictions plus permissives.

Les réactions internationales varient considérablement. L’Union européenne tire parti de son AI Act moins restrictif pour attirer les investissements américains. La Chine accélère ses investissements en IA avec un plan de 200 milliards de yuans sur trois ans. Le Canada, le Royaume-Uni et Israël positionnent comme destinations alternatives pour les entreprises américaines contraintes de délocaliser. Cette fragmentation réglementaire crée de nouveaux équilibres géopolitiques dans l’innovation technologique mondiale.