Depuis ses débuts, l’intelligence artificielle (IA) fascine et intrigue. Pourquoi ? Parce qu’elle promet de révolutionner notre quotidien. Imaginez des machines capables de penser, d’apprendre et de résoudre des problèmes. Cela semble tout droit sorti d’un film de science-fiction, mais c’est notre réalité actuelle.

Dans cet article, nous allons explorer l’histoire de l’IA, de ses origines à ses applications modernes. Nous découvrirons les pionniers qui ont façonné ce domaine, les avancées majeures, ainsi que les défis éthiques et technologiques qui l’accompagnent. Prêt à plonger dans le monde fascinant de l’intelligence artificielle ?

Introduction à l’intelligence artificielle

Définition de l’intelligence artificielle

L’intelligence artificielle (IA) désigne la capacité d’une machine à imiter des fonctions cognitives humaines. Cela inclut des tâches comme l’apprentissage, la raison et la résolution de problèmes. En d’autres termes, l’IA permet aux ordinateurs de traiter des informations et de prendre des décisions similaires à celles des humains.

Il existe deux grandes catégories d’IA :

- IA faible : Conçue pour des tâches spécifiques, comme les assistants vocaux.

- IA forte : Hypothétique, capable de comprendre et de raisonner comme un humain.

Importance et enjeux contemporains

L’intelligence artificielle a des implications majeures dans divers domaines. Voici quelques enjeux contemporains :

- Économie : L’IA peut augmenter la productivité et créer de nouveaux emplois.

- Éthique : Les décisions automatisées soulèvent des questions sur la responsabilité et la transparence.

- Société : L’IA peut influencer les comportements humains et les interactions sociales.

En résumé, l’IA est un outil puissant qui transforme nos vies. Elle pose aussi des défis qu’il faut adresser pour un avenir éthique et durable.

Les origines historiques de l’intelligence artificielle

Les précurseurs et leurs contributions

Avant que l’intelligence artificielle (IA) ne devienne un domaine reconnu, plusieurs penseurs ont jeté les bases de cette science. Des mathématiciens et des philosophes ont commencé à explorer des idées qui allaient aboutir à l’IA.

Parmi les précurseurs, on peut citer :

- Alan Turing (1912-1954) : Il a proposé le célèbre test de Turing, qui évalue si une machine peut se comporter comme un humain.

- John McCarthy : Considéré comme le père de l’IA, il a organisé la première conférence sur l’IA en 1956.

- Marvin Minsky : Il a cofondé le laboratoire d’intelligence artificielle au MIT et a écrit de nombreux ouvrages sur le sujet.

Ces pionniers ont permis de définir les concepts et les objectifs qui guideraient l’IA pour les décennies à venir.

L’apparition du terme ‘intelligence artificielle’

Le terme ‘intelligence artificielle‘ a été utilisé pour la première fois lors de la conférence de Dartmouth en 1956. Cette rencontre a rassemblé des chercheurs de divers domaines, tous désireux d’explorer comment créer des machines capables de penser.

Lors de cette conférence, les participants ont formulé des hypothèses clés :

- Les machines peuvent simuler des processus de pensée humaine.

- Les ordinateurs peuvent résoudre des problèmes complexes.

Cette conférence est souvent considérée comme le véritable point de départ de l’IA moderne. Elle a ouvert la voie à des recherches qui ont façonné notre compréhension actuelle de ce domaine fascinant.

Les grandes étapes de l’évolution de l’IA

L’âge d’or de l’intelligence artificielle (1956-1974)

L’âge d’or de l’intelligence artificielle a débuté lors de la conférence de Dartmouth en 1956. À cette époque, les chercheurs ont commencé à croire que les machines pouvaient imiter l’intelligence humaine.

Durant cette période, plusieurs avancées majeures ont eu lieu :

- Création des premiers programmes capables de jouer aux échecs.

- Développement du logiciel de traitement du langage naturel.

- Introduction des réseaux de neurones simples.

Les chercheurs étaient optimistes. Les progrès semblaient prometteurs et les financements affluaient.

Les hivers de l’IA et leurs conséquences

Malgré cet optimisme, l’IA a connu plusieurs hivers, des périodes de stagnation. Les attentes étaient souvent trop élevées par rapport aux capacités réelles des technologies.

Les principaux hivers de l’IA ont eu lieu dans les années 1970 et 1980. Voici quelques raisons de ces retours en arrière :

- Les limitantes techniques des ordinateurs de l’époque.

- La déception des investisseurs face aux résultats.

- Le manque de données pour former les modèles.

Ces périodes ont freiné le développement de l’intelligence artificielle. Cependant, elles ont également permis de repenser et d’améliorer les approches. Les leçons apprises ont ouvert la voie à de futures avancées.

Les avancées technologiques et théoriques

Le test de Turing et son impact

Le test de Turing, proposé par le mathématicien Alan Turing en 1950, est un critère pour évaluer l’intelligence d’une machine. L’idée est simple : si un humain ne peut pas distinguer une machine d’un autre humain lors d’une conversation, alors la machine peut être considérée comme intelligente.

Ce test a eu un impact considérable sur le développement de l’intelligence artificielle (IA). Il a ouvert la voie à des recherches sur la communication et la compréhension du langage par les machines. De plus, il a suscité des débats éthiques sur la nature de l’intelligence et de la conscience.

Développement des réseaux neuronaux et machine learning

Les réseaux neuronaux imitent le fonctionnement du cerveau humain. Ils sont composés de neurones artificiels qui traitent des informations. Le développement de ces réseaux a été crucial pour l’évolution de l’IA.

Le machine learning (apprentissage automatique) est une branche de l’IA qui permet aux machines d’apprendre à partir de données. Voici quelques points clés :

- Les algorithmes de machine learning s’améliorent avec le temps.

- Ils peuvent identifier des motifs et faire des prédictions.

- Ils sont utilisés dans divers domaines, comme la santé, la finance et l’automobile.

En combinant les réseaux neuronaux et le machine learning, les chercheurs ont réalisé des avancées significatives dans des tâches complexes, comme la reconnaissance d’images et la traduction automatique.

L’intelligence artificielle aujourd’hui

Applications actuelles dans divers secteurs

L’**intelligence artificielle** (IA) est désormais intégrée dans de nombreux secteurs. Elle transforme la façon dont nous travaillons, communiquons et vivons. Voici quelques exemples d’applications :

- Santé : Diagnostic médical, analyse d’images, et personnalisation des traitements.

- Finance : Détection de fraudes, prédiction des marchés, et gestion des investissements.

- Transport : Voitures autonomes, optimisation des itinéraires, et gestion du trafic.

- Éducation : Tutoriels personnalisés, systèmes d’évaluation automatisés, et gestion administrative.

- Marketing : Analyse des données clients, recommandations de produits, et publicités ciblées.

Ces applications montrent comment l’IA améliore l’efficacité et la précision dans différents domaines. Elle aide à résoudre des problèmes complexes et à automatiser des tâches répétitives.

Risques et opportunités de l’IA moderne

Malgré ses avantages, l’IA présente aussi des risques significatifs. Il est essentiel de les comprendre pour en tirer le meilleur parti. Voici quelques points à considérer :

- Éthique : L’utilisation de l’IA soulève des questions sur la vie privée et la surveillance.

- Emploi : L’automatisation peut entraîner des pertes d’emplois dans certains secteurs.

- Bias : Les algorithmes peuvent reproduire des biais humains, affectant l’équité des décisions.

- Contrôle : La dépendance à l’IA peut rendre les systèmes vulnérables aux pannes ou aux cyberattaques.

Pourtant, ces défis offrent aussi des opportunités. En créant des cadres réglementaires, nous pouvons garantir une utilisation responsable et éthique de l’IA. De plus, l’IA peut contribuer à la durabilité et à l’innovation, ouvrant la voie à de nouveaux développements.

Conclusion et perspectives d’avenir

Les défis futurs de l’intelligence artificielle

Alors que l’intelligence artificielle (IA) continue d’évoluer, plusieurs défis se présentent à nous. Parmi eux :

- La sécurité : Protéger les systèmes d’IA contre les cyberattaques est essentiel.

- La transparence : Comprendre comment les algorithmes prennent des décisions est crucial.

- Les biais : Éviter les préjugés dans les données d’entraînement pour garantir des résultats justes.

- La réglementation : Créer des lois pour encadrer l’utilisation de l’IA.

Ces défis nécessitent une collaboration entre scientifiques, ingénieurs et politiques pour construire un avenir sûr et équitable.

Vers une IA éthique et responsable

Le développement d’une IA éthique est devenu une priorité. Cela implique :

- De s’assurer que les technologies respectent la vie privée des utilisateurs.

- De promouvoir des algorithmes justes et inclusifs.

- De garantir que l’IA soit utilisée pour le bien commun.

Les entreprises et les chercheurs doivent travailler ensemble pour établir des normes éthiques. Cela peut inclure des audits réguliers et des protocoles de transparence.

En somme, l’avenir de l’intelligence artificielle dépend de notre capacité à relever ces défis et à construire un système qui bénéficie à tous.

FAQ

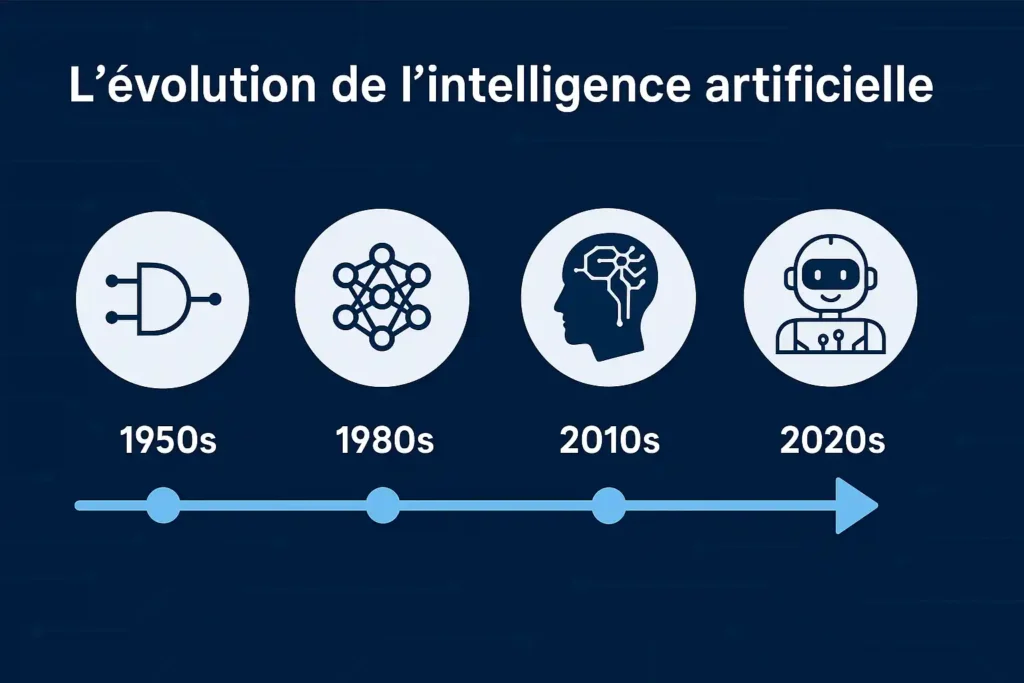

Le concept d’IA remonte aux années 1950 avec Alan Turing. Le terme « intelligence artificielle » a été officialisé en 1956 lors de la conférence de Dartmouth, posant les bases du domaine.

1950s : fondations théoriques (Turing, McCarthy)

1980s : essor des systèmes experts

2012 : percée du deep learning avec AlexNet

2020s : arrivée des modèles géants (GPT, Gemini, Claude…)

Des avancées majeures en puissance de calcul, big data et algorithmes d’apprentissage profond ont permis l’émergence d’IA génératives puissantes.

Santé, finance, industrie, marketing, logistique, cybersécurité, éducation… L’IA est aujourd’hui intégrée dans la quasi-totalité des secteurs.

L’éthique, la régulation, l’automatisation à grande échelle, la souveraineté technologique et la cohabitation homme-machine seront au cœur des débats à venir.